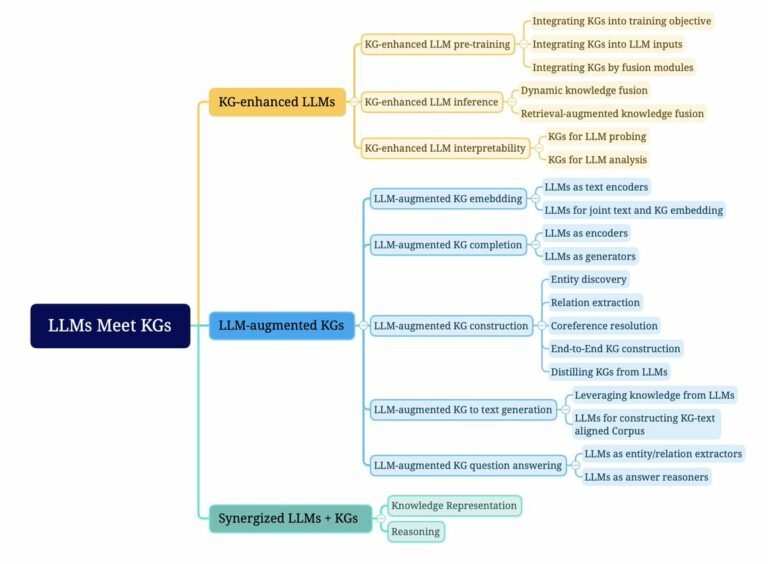

Les graphes de connaissances (KG) et les modèles de langage (LLM) : une fusion puissante

Cet article explore la synergie entre les graphes de connaissances (KG) et les modèles de langage à grande échelle (LLM), révolutionnant l'intelligence artificielle par une compréhension approfondie et contextuelle.